L’universo dell’intelligenza artificiale è in continuo fermento, un ecosistema dove ogni annuncio può ridisegnare gli equilibri. La recente decisione di OpenAI di rilasciare due modelli LLM gpt-oss segna una tappa fondamentale in questo percorso.

Non si tratta di un semplice aggiornamento, ma di un cambio di paradigma che apre le porte a scenari inediti per sviluppatori, ricercatori e aziende. Per la prima volta, la tecnologia che alimenta alcune delle più sofisticate applicazioni AI diventa accessibile a tutti, sotto una licenza permissiva che ne incoraggia l’adozione e la modifica.

Questa mossa strategica democratizza l’accesso a strumenti di altissimo livello, prima confinati nei laboratori di Mountain View. La domanda che sorge spontanea non è più cosa può fare l’AI, ma chi potrà sfruttarne il potenziale. L’introduzione dei modelli OpenAI open source alimenta un dibattito cruciale sulla trasparenza, la sicurezza e la collaborazione nel settore.

Il rilascio di gpt-oss-120b e gpt-oss-20b non è solo una notizia tecnica, ma un invito alla comunità globale a costruire, sperimentare e definire collettivamente il futuro dell’intelligenza artificiale, rendendo la tecnologia più versatile e sicura attraverso un processo di sviluppo decentralizzato e collaborativo.

Indice dei contenuti

Due Modelli, Due Filosofie: 120B vs 20B

La scelta di rilasciare due versioni non è casuale. Risponde a esigenze diverse, offrendo un ventaglio di possibilità che copre sia la ricerca di massima potenza sia la necessità di efficienza operativa.

GPT-OSS-120B: La Potenza al Servizio della Complessità

Il modello gpt-oss-120b, con i suoi 120 miliardi di parametri, rappresenta la punta di diamante dell’offerta. È una risorsa pensata per affrontare compiti che richiedono un’elevata capacità di ragionamento e comprensione del contesto.

La sua architettura complessa lo rende ideale per applicazioni in ambito scientifico, analisi di dati su larga scala e generazione di testo altamente specializzato. Pensiamo, ad esempio, a un’azienda farmaceutica che necessita di analizzare migliaia di documenti di ricerca per identificare nuove molecole promettenti.

Questo modello può accelerare il processo in modo significativo, trovando correlazioni che sfuggirebbero a un’analisi umana. La sua adozione, però, richiede un’infrastruttura hardware considerevole, un fattore da non sottovalutare.

GPT-OSS-20B: Efficienza e Agilità per l’Uso Quotidiano

In contrapposizione, il modello gpt-oss-20b è la soluzione agile. Con 20 miliardi di parametri, offre un bilanciamento ottimale tra prestazioni e risorse computazionali richieste.

Questo lo rende perfetto per l’integrazione in applicazioni consumer, chatbot avanzati o sistemi di assistenza clienti che devono rispondere in tempo reale a un vasto numero di utenti. La sua leggerezza si traduce in costi operativi inferiori e una maggiore facilità di implementazione. Sam Altman ha indicato che potrebbe essere installato in uno smartphone.

È la scelta pragmatica per chi cerca una soluzione OpenAI open source versatile, senza dover investire in hardware da data center. Un esempio pratico è un’app di e-commerce che lo utilizza per fornire descrizioni di prodotto personalizzate in base alla navigazione dell’utente.

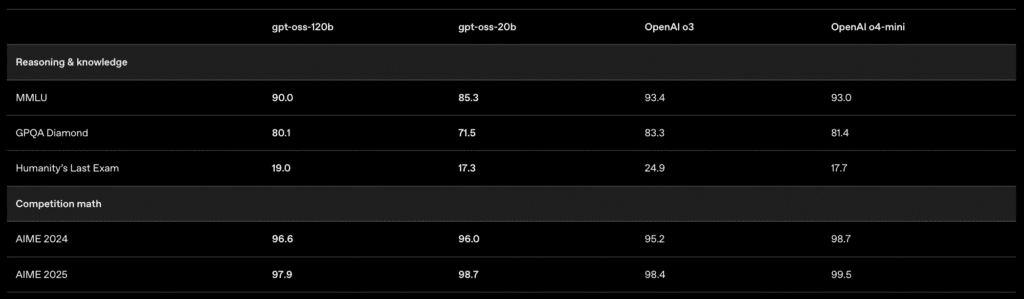

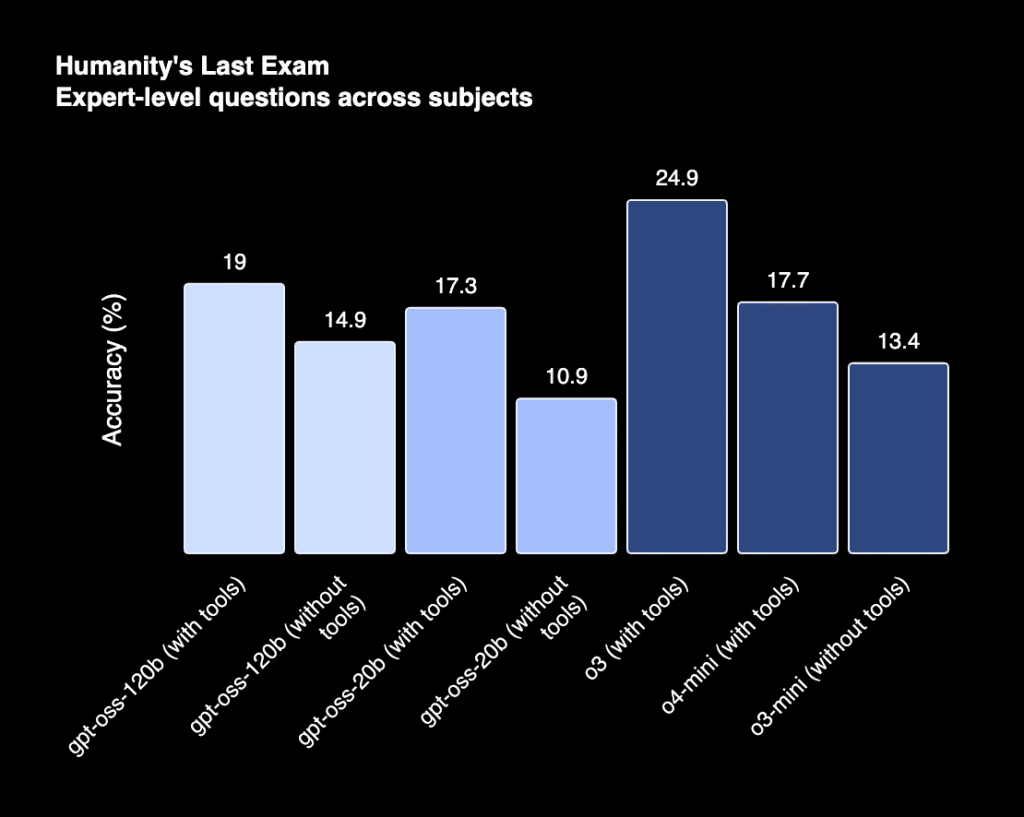

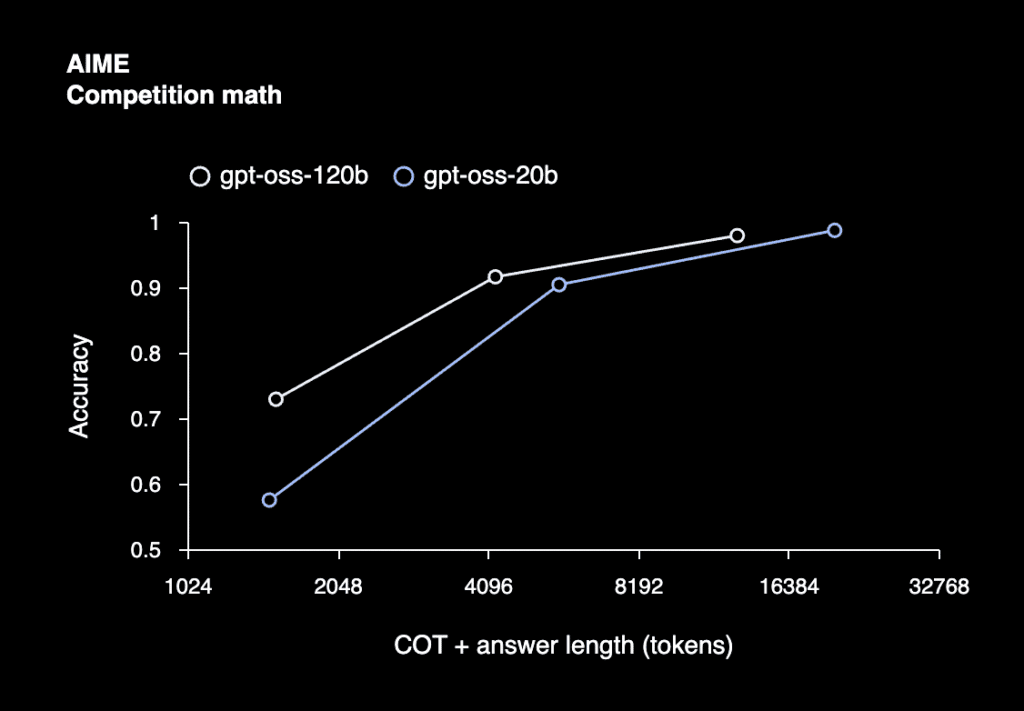

Performance Sotto Esame: I Dati dei Benchmark

Per valutare oggettivamente le capacità dei nuovi modelli LLM gpt-oss, è essenziale analizzare i risultati ottenuti nei benchmark standard del settore. Questi test misurano diverse abilità, dal ragionamento logico alla programmazione, fornendo dati quantitativi sulle loro performance.

Il modello gpt-oss-120b mostra i muscoli soprattutto in compiti complessi. Nel test MMLU (Massive Multitask Language Understanding), che valuta la conoscenza generale e la capacità di problem solving su 57 materie, ottiene un punteggio che lo colloca tra i modelli open source di punta. Anche nel benchmark GSM8K, focalizzato sul ragionamento matematico di livello scolastico, e in HumanEval, che testa la generazione di codice Python, il 120B dimostra prestazioni solide, rendendolo un’opzione affidabile per applicazioni che richiedono un’intelligenza artificiale sofisticata e precisa.

Il gpt-oss-20b, pur essendo più compatto, si difende egregiamente, soprattutto in relazione alla sua efficienza. Nei medesimi benchmark, i suoi punteggi sono inferiori a quelli del fratello maggiore, come è logico attendersi, ma rimangono altamente competitivi nel suo segmento. La sua forza risiede nel rapporto tra prestazioni e risorse computazionali. Offre una soluzione robusta per chi necessita di una risposta rapida e di un’implementazione agile, senza sacrificare eccessivamente l’accuratezza in compiti di linguaggio naturale di uso comune.

Perché Questa Apertura è Così Rilevante?

La decisione di OpenAI non è un gesto isolato. Si inserisce in un trend che vede l’open source come motore di accelerazione tecnologica. Rendere pubblici i modelli LLM gpt-oss ha implicazioni profonde. È una chiara risposta a DeepSeek con il modello R1.

Significa, prima di tutto, maggiore trasparenza. Chiunque può ispezionare il codice, comprenderne il funzionamento e identificare potenziali vulnerabilità o bias. Questo processo di scrutinio collettivo è essenziale per costruire una fiducia solida nella tecnologia.

Inoltre, stimola la concorrenza e l’innovazione. Con l’accesso a modelli così avanzati, startup e università possono competere ad armi quasi pari con i giganti tecnologici, sviluppando soluzioni verticali e altamente specializzate.

Dove Trovare e Come Usare i Modelli

L’accesso ai modelli è stato reso estremamente semplice. OpenAI ha scelto due canali principali per la distribuzione, garantendo massima visibilità e facilità di utilizzo.

Accesso tramite Hugging Face e Sito Ufficiale

Il punto di riferimento per la comunità di sviluppatori è Hugging Face, una piattaforma leader per il machine learning. Qui sono disponibili sia il modello gpt-oss-120b sia il gpt-oss-20b, completi di documentazione e istruzioni per l’implementazione.

In parallelo, il sito ufficiale di OpenAI fornisce una panoramica completa, contestualizzando la scelta strategica e offrendo guide dettagliate. La licenza scelta è la MIT License, una delle più permissive, che consente un ampio riutilizzo anche per scopi commerciali.

Obiezioni e Risposte

Ogni grande cambiamento solleva dubbi. È giusto che sia così. Un’obiezione comune riguarda la sicurezza: rilasciare modelli così potenti non potrebbe favorire un loro uso malevolo? OpenAI ha affrontato questo tema sviluppando i modelli con tecniche di “safety-tuning”, volte a mitigare i rischi e a limitare la generazione di contenuti inappropriati.

Un’altra preoccupazione riguarda il divario di competenze. Non tutti hanno le conoscenze per sfruttare questi strumenti. La risposta sta nella comunità: l’approccio open source favorisce la nascita di tutorial, guide e progetti che abbassano la barriera d’ingresso, rendendo la tecnologia accessibile a un pubblico sempre più vasto.

Domande Frequenti (FAQ)

- Qual è la differenza principale tra i due modelli?

La differenza risiede nella dimensione e nelle risorse richieste. GPT-OSS-120B è più potente ma esigente in termini di hardware; GPT-OSS-20B è più leggero ed efficiente, ideale per applicazioni scalabili. - Posso usare questi modelli per un progetto commerciale?

Sì, la MIT License con cui sono stati rilasciati permette l’uso commerciale, la modifica e la distribuzione, a condizione che la nota di copyright originale sia inclusa. - Ho bisogno di un supercomputer per usarli?

Per il modello da 120 miliardi di parametri, l’hardware necessario è significativo. Sam Altman ha indicato un computer di fascia alta. Per il modello da 20 miliardi, i requisiti sono più contenuti e accessibili a un pubblico più ampio di sviluppatori e piccole imprese. - Sono modelli già pronti all’uso?

I modelli sono pre-addestrati e possono essere utilizzati direttamente per molti compiti. Per esigenze specifiche, può essere necessario un processo di fine-tuning su un dataset personalizzato. - OpenAI offrirà supporto per questi modelli?

Trattandosi di un rilascio open source, il supporto è gestito principalmente dalla comunità attraverso forum e piattaforme come Hugging Face. OpenAI fornisce la documentazione iniziale.