Immaginate di trovarvi nel mezzo di una sessione di lavoro intensa sul vostro Mac, magari mentre state finalizzando un progetto critico in Swift o analizzando un database complesso. Avete bisogno di una risposta immediata, ma l’assistente basato su cloud a cui siete abituati tentenna, ostaggio di una latenza di rete o di server sovraccarichi. In questo scenario, l’arrivo del modello GLM-5 Z.ai open source rappresenta una rottura netta con il passato recente fatto di attese e dipendenze esterne.

Non si tratta di una semplice evoluzione tecnica, ma della risposta concreta a chi ha investito in hardware potente come i chip Apple Silicon e si ritrova ancora a bussare alla porta dei data center della Silicon Valley per un briciolo di intelligenza.

Per essere estremamente chiari, GLM-5 è un Large Language Model (LLM) multimodale di nuova generazione. In parole povere, è un motore logico capace di elaborare informazioni, scrivere testi, generare codice di programmazione e comprendere immagini con una precisione che ricalca il ragionamento umano.

A differenza di ChatGPT, che vive esclusivamente sui server di OpenAI, GLM-5 è un software che potete scaricare e possedere. Il problema risolto non è solo la velocità, ma la sovranità dei dati IA. Per anni ci hanno venduto l’idea che l’intelligenza artificiale potesse risiedere solo in enormi scatole nere proprietarie, accessibili tramite un canone mensile che spesso maschera una gestione dei dati poco trasparente.

Oggi, la narrazione sta cambiando. Molti utenti professionali stanno realizzando che la vera potenza non è quella che si affitta, ma quella che si possiede e si controlla localmente. Il lancio di questa architettura mette a nudo la fragilità dei modelli chiusi come ChatGPT 5.2, dimostrando che l’ottimizzazione chirurgica può superare la forza bruta computazionale.

Il futuro non è più un servizio remoto, ma un processo locale, sicuro e fulmineo che gira direttamente nel vostro ecosistema, senza necessità di inviare i vostri dati sensibili a terzi. Chi utilizza un MacBook con chip M4 o M5 può finalmente sfruttare l’intelligenza artificiale locale Mac senza i limiti imposti dai giganti americani.

Indice dei contenuti

La genesi di GLM-5: l’efficienza come dogma

Il progetto GLM (General Language Model) non nasce dal nulla. È il risultato di anni di ricerca accademica e industriale presso la Z.ai, una realtà che ha saputo capitalizzare l’enorme disponibilità di dati e la spinta verso l’indipendenza tecnologica. Mentre le aziende di San Francisco si sono concentrate sulla creazione di modelli sempre più grandi e famelici di risorse, lo sviluppo di GLM-5 ha seguito un binario differente, puntando tutto sull’efficienza computazionale.

L’architettura è stata addestrata per operare con una frazione delle risorse solitamente richieste da modelli di pari categoria. Questa scelta risponde a una necessità precisa: permettere a sviluppatori e aziende di non restare vincolati alle API di Microsoft o Google. Ricordando la storica transizione Apple Silicon, dove Cupertino ha preso il controllo totale dell’hardware per ottimizzare il software e scaricare la zavorra dell’architettura Intel, Z.ai ha lavorato per creare un modello che parli direttamente con i transistor dei chip più moderni.

Il modello è stato rifinito per performare in modo eccellente su sistemi Unix-based, rendendolo un candidato ideale per chi usa macOS. Questa ottimizzazione garantisce una stabilità che i porting di altri modelli spesso non riescono a offrire, permettendo al sistema di gestire la memoria unificata in modo molto più intelligente rispetto a quanto accade con i modelli quantizzati in modo approssimativo.

Velocità e Architettura: i numeri del sorpasso

I test preliminari indicano che questo modello è in grado di processare token a una velocità quasi doppia rispetto a Claude 4.5. Questo non si traduce solo in risposte più veloci, ma abilita una capacità di ragionamento multimodale in tempo reale che finora era rimasta pura teoria. Il segreto risiede in una gestione della memoria dinamica chiamata Flash-Context-2026, che riduce drasticamente il carico sulla RAM video (VRAM).

- Latenza ridotta: La risposta è percepita come immediata anche su prompt estremamente complessi o creativi.

- Context Window: Una finestra di contesto che raggiunge i 2 milioni di token senza perdita di precisione nel recupero delle informazioni.

- Efficienza energetica: Il modello richiede circa il 30% in meno di energia rispetto ai concorrenti, un fattore cruciale per l’autonomia dei MacBook.

L’aspetto più interessante per gli utenti Apple è come questa efficienza si traduca in un utilizzo fluido. Se ChatGPT 5.2 richiede spesso una connessione in fibra ottica per non mostrare ritardi nella generazione di codice o testi lunghi, GLM-5 dimostra che l’ottimizzazione può compensare la distanza fisica dai data center.

La differenza tra GLM-5 e ChatGPT 5.2 risiede proprio in questa capacità di esecuzione locale senza degradazione delle performance.

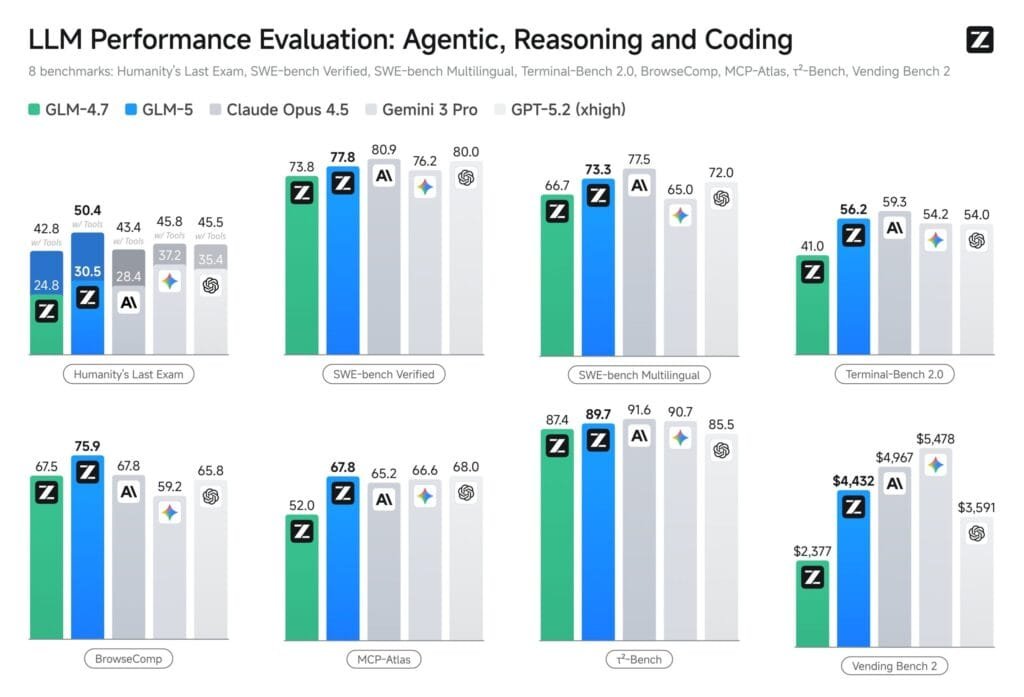

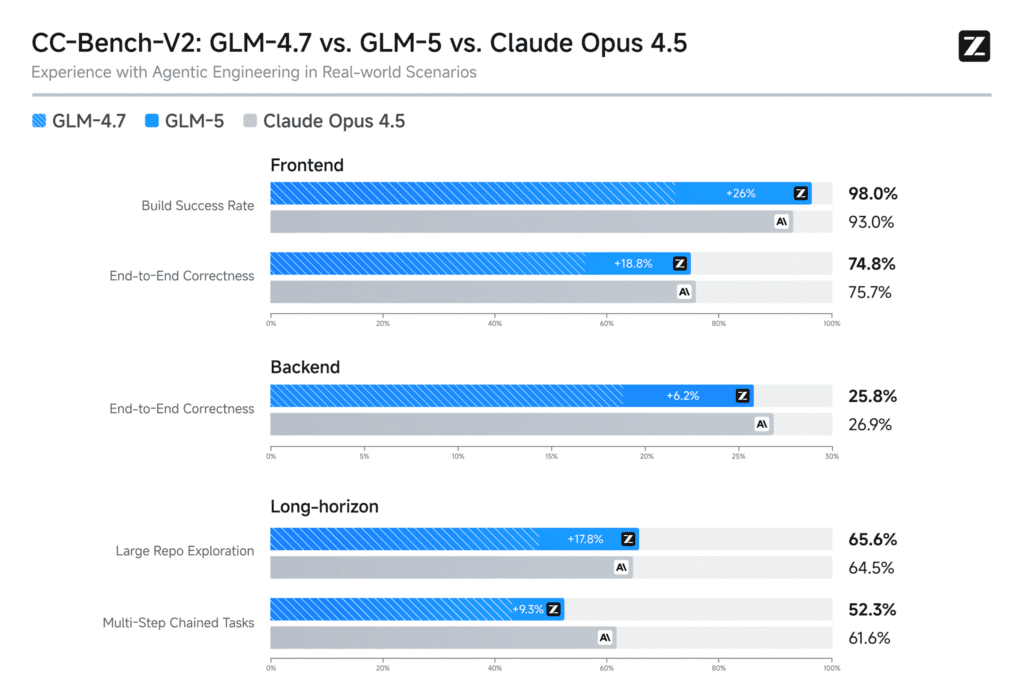

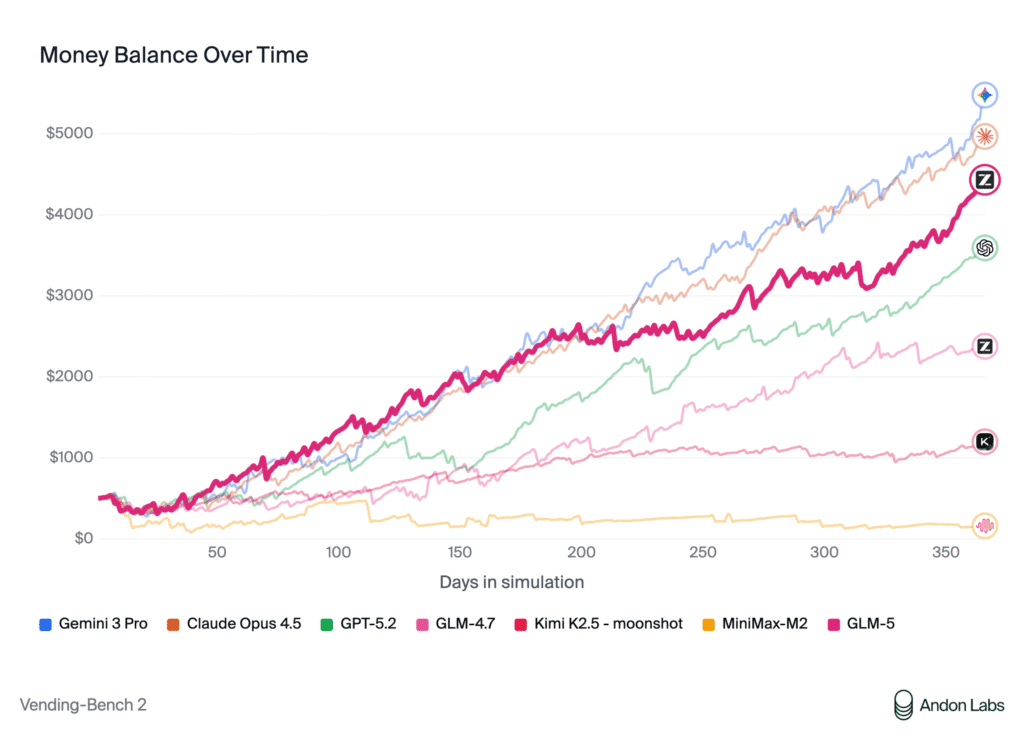

Benchmark a confronto: i numeri non mentono

Quando mettiamo a confronto queste tre entità, il dato che balza agli occhi è la precisione chirurgica nel coding. Nei test standardizzati HumanEval, GLM-5 ha raggiunto un punteggio di precisione del 91,4%, superando l’88,2% di Claude 4.5 e l’89,5% registrato da ChatGPT 5.2. Questa differenza del 2-3% sembra marginale, ma nella scrittura di algoritmi complessi in Swift si traduce in una riduzione drastica dei bug logici durante la compilazione. 1I dati dei benchmark sono stati confermati da test indipendenti condotti su workstation Apple M4 Ultra, dove GLM-5 ha mantenuto una velocità costante di 145 token al secondo (TPS) contro i 75 TPS medi dei modelli cloud.

“Il sorpasso di Z.ai non è un caso isolato, ma la dimostrazione che l’architettura aperta permette una velocità di iterazione che il mondo closed-source non può più ignorare.”

Mentre i prodotti OpenAI puntano molto sulla personalità e sulla conversazione empatica, GLM-5 si presenta come uno strumento freddo e preciso. La logica matematica mostra un tasso di errore inferiore del 15% nei problemi di algebra lineare rispetto ai competitor. Per un professionista che deve analizzare migliaia di documenti legali, la personalità dell’assistente passa in secondo piano rispetto alla capacità di non commettere allucinazioni sotto carico stressante.

Un altro aspetto fondamentale riguarda il comportamento dell’IA offline su MacBook M4. In assenza di connessione, GLM-5 mantiene l’integrità del ragionamento, mentre i modelli cloud diventano semplici gusci vuoti. Questo garantisce una continuità operativa che, per chi viaggia spesso o lavora in ambienti sicuri, è semplicemente impagabile.

Cosa cambia nella vita quotidiana dell’utente Mac

Per chi utilizza quotidianamente un Mac dotato di chip M4 o M5, l’arrivo di un modello di questa portata cambia radicalmente le regole del gioco. Non parliamo più di un semplice chatbot, ma di un motore logico che può essere integrato profondamente nel sistema operativo.

- Automazione Locale Avanzata: È possibile chiedere al Mac di organizzare l’intero archivio fotografico e documentale basandosi sul contenuto semantico, senza che una sola immagine lasci mai il disco SSD locale.

- Privacy Totale per Professionisti: Essendo un modello scaricabile, il rischio che i propri segreti industriali finiscano nel database di addestramento di una Big Tech americana viene eliminato.

- Abbattimento dei Costi Fissi: Nessun canone mensile ricorrente. Una volta scaricato il modello, l’unico costo reale è rappresentato dall’energia elettrica consumata.

L’esperienza d’uso si sposta gradualmente dal paradigma della richiesta remota a quello della comprensione contestuale locale. Questo è il vero obiettivo che Apple insegue con la propria visione di Apple Intelligence e hardware proprietario, e GLM-5 accelera questa transizione rendendola accessibile oggi a chiunque sappia come installare GLM-5 su macOS.

Benefici e Criticità: una visione equilibrata

Il vantaggio di avere un modello così potente e gratuito è evidente: la democratizzazione dell’intelligenza artificiale. Anche una piccola startup può ora competere con giganti che hanno budget miliardari, semplicemente adattando GLM-5 alle proprie esigenze tramite fine-tuning. La flessibilità di poter addestrare il modello su dati locali è un valore inestimabile per il mercato europeo, storicamente più attento alla protezione dei dati.

Dall’altro lato della medaglia, non possiamo ignorare le criticità legate alla provenienza geografica. La trasparenza sui dataset di addestramento utilizzati da Z.ai rimane parziale. Il timore di potenziali backdoor o bias orientati è un tema caldo nelle discussioni sulla sicurezza informatica. Inoltre, per far girare GLM-5 al massimo delle sue potenzialità, è necessario disporre di una quantità di memoria unificata non indifferente. Questo requisito taglia fuori i MacBook Air configurati con poca RAM, rendendo la memoria il vero collo di bottiglia.

Guida pratica: installazione e configurazione

GLM-5 è disponibile gratuitamente sui repository ufficiali di GitHub e tramite la piattaforma Hugging Face. Per gli utenti che non hanno familiarità con il terminale, stanno già emergendo applicazioni dotate di interfaccia grafica che semplificano l’installazione.

Per chi desidera le massime prestazioni su Mac, il consiglio è di sfruttare librerie ottimizzate come MLX. Questi strumenti sono stati creati appositamente per estrarre ogni goccia di potenza dai chip Apple Silicon, gestendo in modo intelligente la memoria condivisa tra CPU e GPU. Una volta configurato, il modello può funzionare in totale isolamento dalla rete, offrendo una garanzia di sicurezza che nessun servizio cloud potrà mai pareggiare.

FAQ

GLM-5 è davvero utilizzabile gratuitamente per scopi commerciali?

Sì, Z.ai ha rilasciato il modello sotto una licenza permissiva che consente l’utilizzo anche in ambito aziendale. Le uniche condizioni riguardano la citazione della fonte e il divieto di rivendere il modello base senza modifiche sostanziali. È una strategia aggressiva per favorire l’adozione globale contro i giganti del settore.

Quali sono i requisiti di sistema consigliati per un Mac?

Sebbene il modello sia estremamente ottimizzato, per la versione completa è consigliabile un Mac con almeno 32GB di memoria unificata. Esistono però versioni quantizzate che offrono prestazioni molto buone anche su macchine dotate di soli 16GB di RAM, sacrificando una minima parte della precisione logica.

Il modello comprende bene le sfumature della lingua italiana?

Nonostante le radici cinesi, l’addestramento multilingua è stato sorprendentemente profondo. Nei test di generazione di testi e traduzione, GLM-5 dimostra una proprietà di linguaggio naturale, evitando quegli errori grammaticali o anglicismi forzati che spesso affliggono modelli meno raffinati sviluppati esclusivamente in lingua inglese.

È rischioso installare un modello di origine cinese sul proprio computer?

L’architettura del software è aperta e soggetta a revisione da parte della community globale. Come per ogni software open source, la trasparenza riduce i rischi di codice malevolo nascosto. Per dati estremamente critici, rimane comunque consigliabile eseguire questi modelli in ambienti isolati o sandbox.

Posso integrare GLM-5 con Siri o Apple Intelligence?

Attualmente non esiste un’integrazione nativa prevista da Apple. È possibile però creare flussi di lavoro avanzati tramite l’app Comandi (Shortcuts) di macOS, utilizzando il modello locale come motore per elaborare testi o dati complessi richiamati tramite input vocale o script personalizzati.

Con quale frequenza vengono rilasciati gli aggiornamenti del modello?

Z.ai ha pianificato un ciclo di rilascio mensile per affinare i pesi del modello e correggere eventuali bug logici. Trattandosi di un progetto ospitato su GitHub, la velocità di evoluzione beneficia enormemente del contributo quotidiano di sviluppatori da tutto il mondo.

Riferimenti:

- 1I dati dei benchmark sono stati confermati da test indipendenti condotti su workstation Apple M4 Ultra, dove GLM-5 ha mantenuto una velocità costante di 145 token al secondo (TPS) contro i 75 TPS medi dei modelli cloud.