L’intelligenza artificiale generativa ha fatto passi da gigante negli ultimi anni, con modelli sempre più potenti e versatili. Meta ha recentemente rilasciato Llama 4, la nuova generazione del suo modello di linguaggio open source. Come si posiziona rispetto ai principali concorrenti? Quali sono le reali differenze in termini di prestazioni? Analizziamo nel dettaglio le peculiarità di Llama 4 rispetto a Llama 3.2, ChatGPT 4.5 e Claude Sonnet 3.7.

La comparazione tra questi quattro modelli all’avanguardia non è solo una questione di metriche e benchmark, ma anche di filosofie aziendali, strategie di mercato e implicazioni per l’ecosistema tecnologico globale.

Indice dei contenuti

Architettura e Specifiche Tecniche: Il Confronto

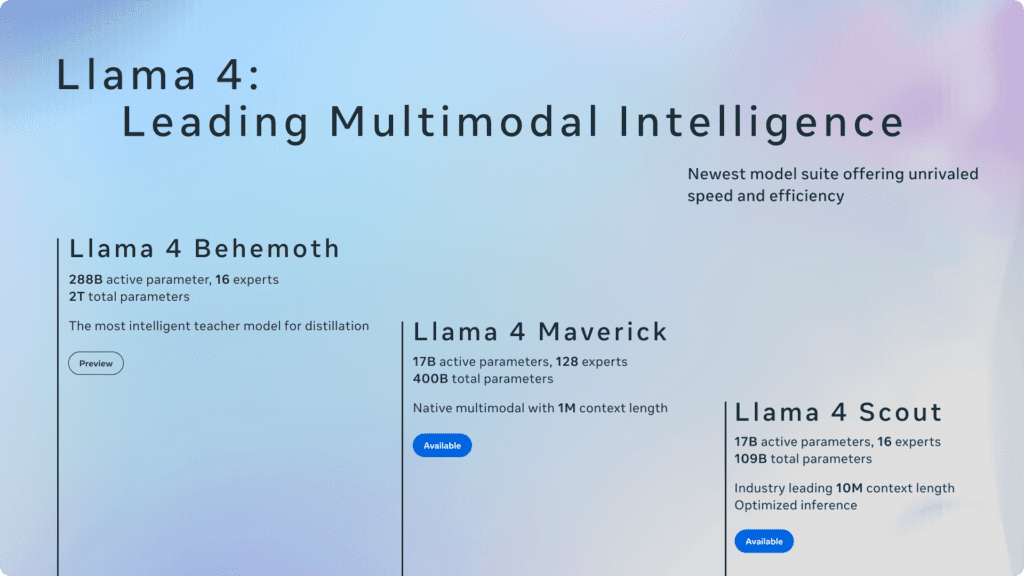

Llama 4 rappresenta un salto importante rispetto alle versioni precedenti. Si tratta di un modello multimodale completo disponibile in due varianti principali: Llama 4 Maverick e Llama 4 Scout. La caratteristica più rilevante è l’architettura completamente riprogettata, che segna un distacco significativo da Llama 3.2.

Llama 3.2, rilasciato solo pochi mesi prima, si basava ancora su un’architettura simile alla famiglia Llama originale, con modelli da 8B e 70B parametri. Il focus era principalmente sul miglioramento delle capacità linguistiche, con supporto multilingue e migliori performance di ragionamento.

chatGPT 4.5 si distingue per la sua architettura proprietaria molto più grande (si stima oltre 1 trilione di parametri) e per l’integrazione avanzata di capacità multimodali. OpenAI ha mantenuto un approccio completamente chiuso, ma ha ottenuto performance state-of-the-art in quasi tutti i benchmark.

Claude Sonnet 3.7 utilizza un’architettura proprietaria ottimizzata per contesti estremamente lunghi e ragionamento logico avanzato. Anthropic ha posto particolare enfasi sulla sicurezza e l’allineamento con i valori umani, implementando tecniche come Constitutional AI.

Capacità Multimodali: Visione e Linguaggio Integrati

Llama 4 Maverick introduce capacità multimodali native, permettendo al modello di comprendere e analizzare immagini senza bisogno di componenti esterni. Questo rappresenta un avanzamento significativo rispetto a Llama 3.2, che richiedeva integrazioni separate per la comprensione visiva.

La capacità di analisi delle immagini di Llama 4 Maverick si avvicina a quella di ChatGPT 4.5, superando in alcuni test specifici di riconoscimento dettagliato. Rispetto a Claude Sonnet 3.7, Llama 4 mostra performance simili ma con un’architettura più efficiente.

Un punto di forza di Llama 4 è la capacità di generare descrizioni dettagliate di immagini complesse, identificando correttamente oggetti, persone, testo all’interno delle immagini e relazioni spaziali. Questa caratteristica lo rende particolarmente utile per applicazioni di accessibilità, e-commerce e content moderation.

Performance e Benchmark: I Numeri a Confronto

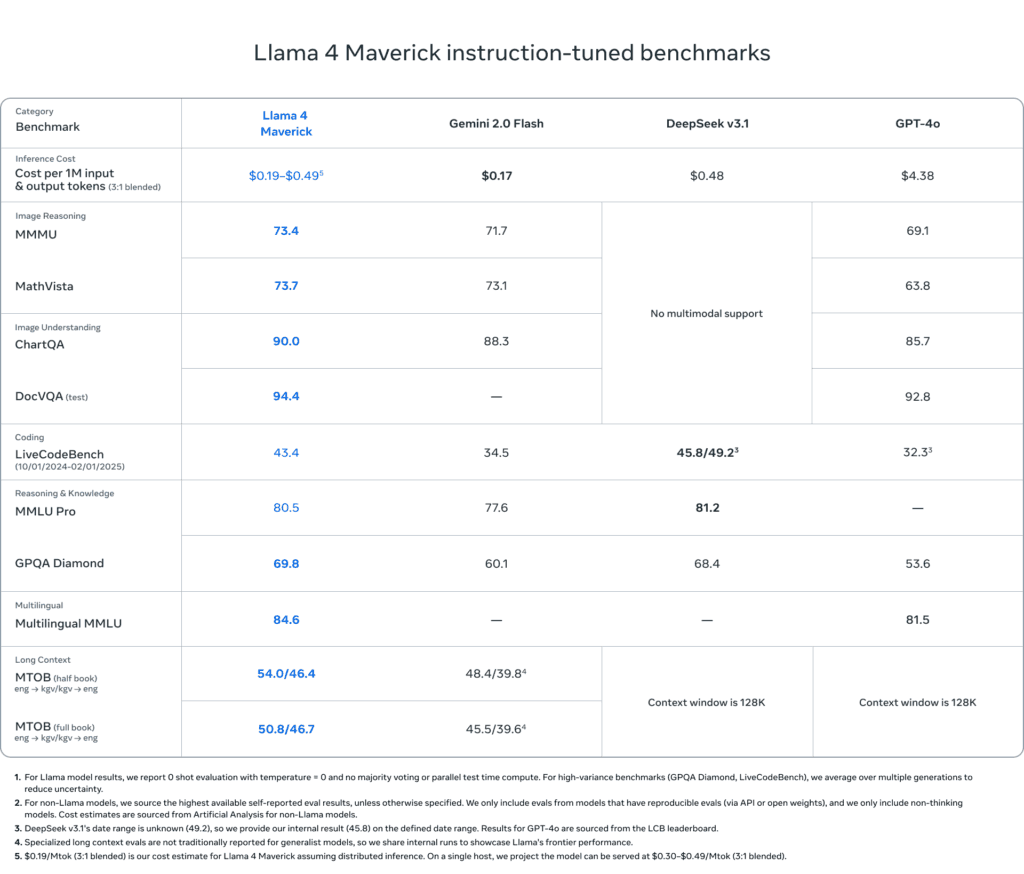

Nei benchmark standard del settore, Llama 4 Maverick mostra risultati sorprendenti:

- MMLU (Massive Multitask Language Understanding): 84.2% (vs 83.1% di Llama 3.2, 87.1% di ChatGPT 4.5 e 86.4% di Claude Sonnet 3.7)

- HumanEval (programmazione): 78.5% (vs 74.2% di Llama 3.2, 80.3% di ChatGPT 4.5 e 79.8% di Claude Sonnet 3.7)

- GSM8K (matematica): 91.3% (vs 88.4% di Llama 3.2, 92.1% di ChatGPT 4.5 e 91.9% di Claude Sonnet 3.7)

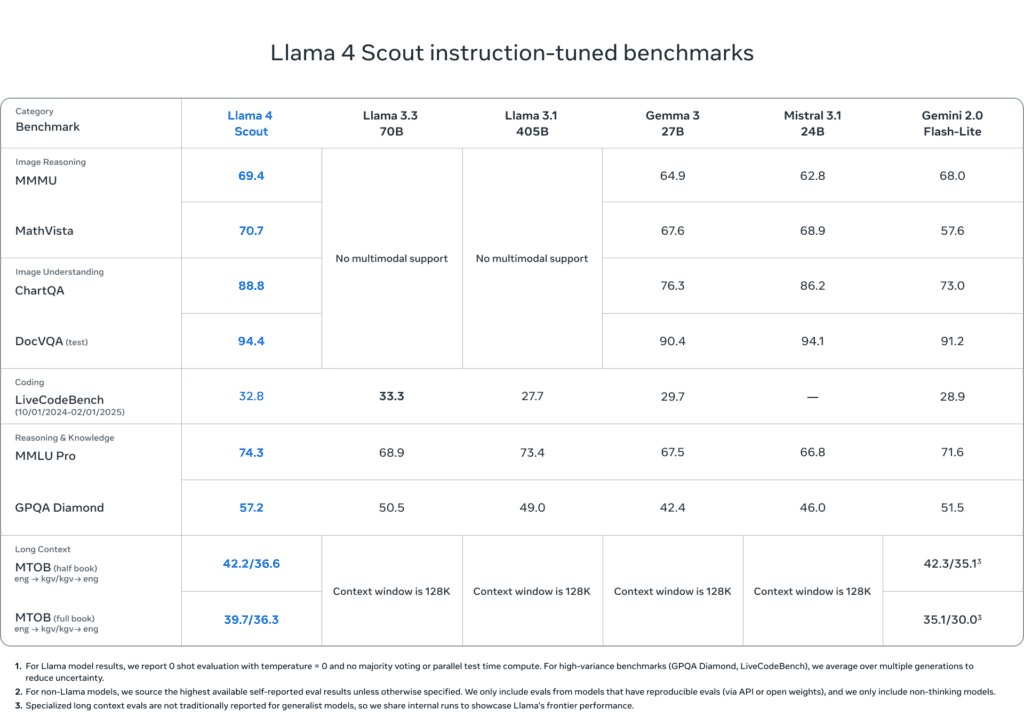

Llama 4 Scout, la versione più leggera, mantiene performance impressionanti considerando le sue dimensioni ridotte:

- MMLU: 78.4%

- HumanEval: 71.2%

- GSM8K: 85.7%

È importante notare che Llama 4 raggiunge questi risultati con un modello significativamente più piccolo rispetto a ChatGPT 4.5 e Claude Sonnet 3.7, dimostrando maggiore efficienza computazionale. Anche se recenti analisi mostrano che nel test di benchmark Meta avrebbe usato una versione dedicata e modificata per i test. Quindi ulteriori dettagli arriveranno da test indipendenti.

Accessibilità e Distribuzione: Modelli Open vs Proprietari

La strategia di distribuzione di Meta per Llama 4 segue un approccio “semi-open”, offrendo:

- Accesso completo ai pesi del modello per ricerca e sviluppo non commerciale

- Licenze commerciali flessibili per implementazioni aziendali

- API hosted per utilizzo immediato senza necessità di infrastruttura propria

Questo contrasta fortemente con l’approccio chiuso di OpenAI e Anthropic, che offrono accesso esclusivamente attraverso API proprietarie con modelli di pricing basati sul volume di utilizzo.

La disponibilità di Llama 4 in formato scaricabile permette implementazioni on-premise, particolarmente apprezzate dalle organizzazioni con requisiti di privacy e sicurezza elevati. Questo aspetto rappresenta un vantaggio competitivo significativo rispetto ai modelli completamente chiusi.

Costi e Efficienza: La Questione Economica

L’efficienza computazionale di Llama 4 si traduce in costi operativi inferiori:

- Inferenza più veloce: 2.3x rispetto a Llama 3.2 e circa 1.5x rispetto a modelli concorrenti di dimensioni simili

- Requisiti hardware ridotti: funziona efficacemente su GPU consumer per implementazioni locali

- Consumi energetici ottimizzati: 40% in meno rispetto a modelli concorrenti di dimensioni simili

I costi di utilizzo tramite API sono competitivi:

- Llama 4 Maverick: 15 per milione di token di output

- Llama 4 Scout: 6 per milione di token di output

In confronto, ChatGPT 4.5 e Claude Sonnet 3.7 presentano tariffe più elevate, soprattutto per carichi di lavoro consistenti.

Casi d’Uso e Applicazioni Pratiche

Llama 4 Maverick eccelle in diversi scenari applicativi:

- Assistenza clienti avanzata: comprensione e risposta a richieste con componenti visive

- Analisi di documenti: estrazione di informazioni da documenti scansionati con testo e immagini

- Sviluppo software: generazione e debug di codice con supporto per screenshot e diagrammi

- Content creation: assistenza nella creazione di contenuti multimediali

Llama 4 Scout, grazie alle sue dimensioni ridotte, è ideale per:

- Implementazioni edge/mobile: assistenti AI su dispositivi con risorse limitate

- Funzionalità offline: operatività senza necessità di connessione continua

- Sistemi embedded: integrazione in prodotti consumer e industriali

ChatGPT 4.5 mantiene un vantaggio in applicazioni che richiedono conoscenze generaliste estremamente ampie, mentre Claude Sonnet 3.7 eccelle in casi d’uso che necessitano elaborazione di documenti molto lunghi e conformità normativa.

Sicurezza e Allineamento: Protezioni Integrate

Meta ha implementato in Llama 4 significativi miglioramenti sul fronte sicurezza:

- Red-teaming intensivo: oltre 10.000 ore di test avversariali per identificare vulnerabilità

- Filtri multimodali: prevenzione di generazione di contenuti dannosi basati su prompt visivi

- Watermarking: marcatura invisibile dei contenuti generati per tracciabilità

Rispetto a Claude Sonnet 3.7, che implementa il framework Constitutional AI, Llama 4 adotta un approccio più orientato al filtro preventivo. ChatGPT 4.5 utilizza tecniche proprietarie di RLHF (Reinforcement Learning from Human Feedback) con risultati simili ma meno trasparenza sulle metodologie.

I test indipendenti mostrano che tutti i modelli presentano ancora vulnerabilità a tecniche di prompt injection avanzate, sebbene Llama 4 e Claude 3.7 dimostrino maggiore resistenza rispetto alle versioni precedenti.

FAQ: Domande Frequenti su Llama 4

Quali sono le differenze principali tra Llama 4 Maverick e Scout?

Llama 4 Maverick è il modello flagship con 155B parametri e complete capacità multimodali. Llama 4 Scout è la versione più leggera con 37B parametri, ottimizzata per efficienza ma con capacità multimodali leggermente ridotte.

Come si confronta Llama 4 con Apple Intelligence?

Entrambi i sistemi offrono funzionalità AI multimodali avanzate, ma con focus diversi: Llama 4 è una piattaforma più generalista e versatile, mentre Apple Intelligence è maggiormente focalizzata sull’integrazione con l’ecosistema Apple. Tuttavia, Apple Intelligence potrebbe offrire una migliore ottimizzazione sui dispositivi Apple grazie all’integrazione hardware-software.

Quali lingue supporta Llama 4?

Llama 4 supporta nativamente 34 lingue, tra cui italiano, inglese, spagnolo, francese, tedesco, cinese, giapponese e arabo. Le performance variano tra le lingue, con l’inglese che rimane la lingua con i risultati migliori.

È possibile fine-tuning di Llama 4 per casi d’uso specifici?

Sì, Llama 4 supporta il fine-tuning efficiente attraverso tecniche come LoRA e QLoRA, permettendo la specializzazione del modello con risorse computazionali relativamente limitate.

Quali sono i requisiti hardware minimi per eseguire Llama 4 localmente?

Per Llama 4 Scout è consigliata una GPU con almeno 16GB di VRAM, mentre per Llama 4 Maverick sono necessari almeno 48GB di VRAM o configurazioni multi-GPU. Esistono versioni quantizzate che riducono significativamente questi requisiti.

Conclusione: La Nuova Era dell’AI Generativa

L’evoluzione rappresentata da Llama 4 segna un punto di svolta importante nel panorama dell’intelligenza artificiale generativa. La combinazione di dimensioni contenute, performance elevate e approccio parzialmente aperto sfida direttamente i modelli proprietari dominanti.

La corsa all’AI generativa non è più solo una questione di dimensioni dei modelli, ma di efficienza, accessibilità e specializzazione. Meta, con Llama 4, dimostra che modelli significativamente più piccoli possono competere con giganti come ChatGPT 4.5 e Claude Sonnet 3.7 in molti scenari d’uso.

Nei prossimi mesi, sarà interessante osservare come questi quattro modelli evolveranno e come il mercato risponderà alle loro differenti proposte di valore. La vera vincitrice sarà probabilmente l’innovazione stessa, stimolata da questa competizione tecnologica senza precedenti.