La tecnologia sta superando il confine della semplice utilità per entrare nel campo dell’espressione pura. Lo abbiamo visto con la fotografia computazionale e il montaggio video automatizzato su iPhone. Oggi, con Lyria 3 in Gemini, la sfida si sposta sulla generazione sonora. La musica, da sempre considerata l’ultima frontiera dell’ispirazione umana, diventa terreno di conquista per gli algoritmi.

L’integrazione di questo motore sonoro nell’assistente Google segna un punto di rottura. Per chi osserva l’ecosistema Apple da decenni, il parallelo con il debutto di Garage Band è immediato. Nel 2004, Steve Jobs voleva democratizzare la musica eliminando i costi degli studi fisici. Tuttavia, Garage Band richiedeva una direzione umana: scelta dei loop, senso del ritmo e gusto artistico. Google ora propone l’automazione totale. Non si suona più; si descrive un’emozione e si attende il risultato.

Questa creazione musica AI solleva interrogativi profondi. In un mercato già saturo, che valore avrà il talento di chi domina uno strumento se chiunque può generare una traccia perfetta in pochi secondi? Non è solo un tema tecnico, ma un cambiamento d’identità per l’intera industria discografica e per il concetto stesso di artista nell’era digitale.

Indice dei contenuti

Cos’è Lyria 3 e come trasforma Gemini in uno studio virtuale

Sviluppato da Google DeepMind, Lyria 3 è un modello di modellazione audio che punta alla fedeltà assoluta. A differenza dei sistemi precedenti, che producevano tracce distorte o prive di logica armonica, questo motore gestisce la coerenza temporale con estrema precisione. Non “incolla” campioni esistenti, ma genera l’audio nota dopo nota, basandosi sulla probabilità statistica delle frequenze.

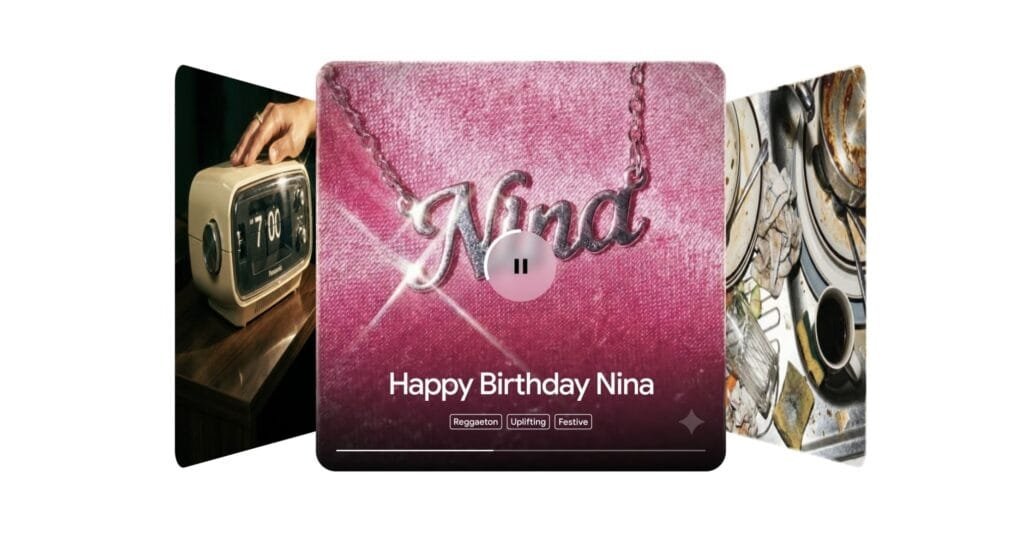

L’accesso tramite Gemini rende la creazione di musica AI una funzione di massa. Non servono plugin pesanti o competenze da fonico; basta un prompt testuale. La potenza di calcolo necessaria, un tempo riservata a server dedicati, è ora disponibile via cloud su qualsiasi dispositivo. Il risultato è spesso indistinguibile da una produzione professionale, risolvendo il limite storico della fluidità sonora nei modelli generativi.

Per i dettagli tecnici, è utile consultare la documentazione di DeepMind. Il modello gestisce transizioni armoniche complesse che prima mandavano in crisi le reti neurali. Mountain View punta a eliminare la burocrazia creativa, offrendo audio originale istantaneo per chiunque abbia un’idea e un account Google.

Casi d’uso: come usare Lyria 3 per podcast e contenuti social

Il settore dei creator è il primo beneficiario di questa tecnologia. Chi gestisce canali social o YouTube può generare colonne sonore originali evitando le complicazioni del copyright. È una soluzione definitiva per chi cerca temi specifici senza navigare per ore in librerie stock spesso mediocri e costose.

Un utilizzo strategico è capire come usare Lyria 3 per podcast. Spesso sigle e tappeti sonori non si adattano al ritmo del parlato. Con l’assistente di Google, è possibile richiedere basi che aumentino di intensità o cambino atmosfera in base ai momenti di tensione dello script. Questa flessibilità era prima esclusiva di chi poteva permettersi un compositore dedicato.

Anche lo storytelling digitale ne esce potenziato. Dalla sonorizzazione di audiolibri alla didattica musicale, dove gli studenti possono esplorare armonizzazioni alternative, il tool funge da compagno di brainstorming. Rimane però la natura di intermediario: Google elimina il passaggio tecnico attraverso software come Logic Pro, puntando tutto sulla velocità. Per i professionisti abituati al controllo millimetrico offerto da Apple, questa semplicità può risultare un limite.

Cosa cambia concretamente per chi usa già iPhone e Mac

L’arrivo di Lyria 3 impatta direttamente sul flusso di lavoro di chi crea su dispositivi Apple. La barriera d’ingresso per produrre audio di qualità è crollata. Non serve più teoria musicale per creare un jingle efficace. Questo porterà a una proliferazione di contenuti unici, ma potenzialmente meno profondi a livello emotivo a causa della facilità di produzione.

Il risparmio di tempo è il beneficio più evidente. Tutto avviene nello stesso ambiente di scrittura del post o del video.

Su iPhone, la generazione via browser offre una flessibilità operativa enorme, permettendo di finalizzare progetti sonori senza una workstation fissa. È la portabilità della creazione che Apple promuove con l’Apple Silicon, ma interpretata da Google attraverso l’intelligenza artificiale pura.

Per un confronto su come queste tecnologie evolvono a Cupertino, consigliamo l’analisi sulla intelligenza artificiale su Mac. La divergenza è chiara: Apple potenzia l’utente con strumenti hardware, Google tende a sostituire l’azione manuale con l’intento verbale via cloud.

Benefici e criticità del nuovo modello Google

L’efficienza produttiva è il vantaggio indiscutibile. La creazione di musica AI abbatte i costi per i piccoli creator indipendenti, offrendo libertà espressiva a chi non ha formazione tecnica. Sul fronte della sicurezza, Google ha introdotto SynthID, un watermark impercettibile che garantisce la tracciabilità dell’audio generato, fondamentale per prevenire abusi e deepfake.

Le criticità rimangono però centrali. Il primo nodo è il diritto d’autore della musica generata dall’IA. Sebbene Google dichiari collaborazioni con l’industria, resta il dubbio etico sull’uso di basi di dati create da artisti umani per addestrare un concorrente algoritmico. C’è inoltre il rischio di una “omogeneizzazione sonora”: se tutti usano lo stesso modello, la musica perderà quelle imperfezioni che rendono un brano memorabile.

“La tecnologia dovrebbe essere un’estensione della mano dell’artista, non la mano stessa che regge il pennello.”

I limiti di Lyria 3 Google DeepMind riguardano anche la struttura delle composizioni. Il sistema eccelle nei segmenti brevi e ripetitivi, ma fatica a gestire la coerenza narrativa di brani lunghi o sinfonie complesse. La macchina non possiede ancora l’intenzionalità artistica necessaria per strutture macroscopiche di lungo respiro.

Analisi critica: automazione contro artigianalità digitale

Il futuro creativo si divide tra due visioni. L’automazione di Google vede la musica come un servizio “on-demand” rapido. La visione Apple, invece, mantiene lo strumento al centro, come espansione delle capacità umane che richiede studio. È lo stesso percorso fatto dalla fotografia: gli smartphone non hanno ucciso le reflex, hanno solo cambiato il modo di scattare della massa.

Il rischio di “lock-in” tecnologico non va sottovalutato.

Affidarsi al cloud significa cedere il controllo sulla propria opera. Se le policy di Google cambiano, il proprio “studio virtuale” potrebbe sparire. Qui l’approccio locale dell’Apple Silicon garantisce un’indipendenza professionale superiore.

Nonostante i dubbi, la comodità vincerà per gran parte dell’utenza. La tentazione di avere una base pronta in pochi secondi è troppo forte.

Per approfondire, rimandiamo al comunicato ufficiale di Google. Il futuro della musica non si scrive più solo sullo spartito, ma nel codice.

FAQ

Come creare canzoni con Gemini Lyria?

Accedi alla versione avanzata di Gemini e invia un prompt dettagliato su genere, atmosfera e strumenti. Più sarai specifico su ritmi e tonalità, più il risultato sarà vicino alle tue aspettative.

Quali sono i limiti di Lyria 3 Google DeepMind?

La durata dei brani è limitata a segmenti brevi. Il sistema fatica con progressioni armoniche molto lunghe e alcune sfumature emotive del cantato possono ancora risultare eccessivamente “pulite” o artificiali.

Esistono problemi per il diritto d’autore della musica generata AI?

La legge è in evoluzione. Molte giurisdizioni non riconoscono il copyright a un software, rendendo difficile proteggere legalmente una traccia generata dall’IA contro l’uso di terzi. Monitora sempre i termini di servizio di Google.

Come funziona il watermark SynthID nelle tracce audio?

È un segnale digitale invisibile inserito nell’onda sonora. Non altera la qualità per l’ascoltatore, ma permette ai software di rilevare immediatamente se il contenuto è sintetico, garantendo trasparenza.

Lyria 3 è disponibile per tutti gli utenti di Gemini?

L’implementazione è graduale. Attualmente è in fase di testing in mercati selezionati. Google prevede una diffusione globale quest’anno, inclusa l’integrazione in Google Workspace.