La WWDC 2025 ha segnato un momento cruciale per l’intelligenza artificiale nell’ecosistema Apple, con l’introduzione di aggiornamenti significativi ai suoi Foundation Language Models (FLM) e, soprattutto, del nuovo Foundation Models framework.

Questa mossa strategica non si limita a potenziare le funzionalità di Apple Intelligence, ma apre un mondo di possibilità per gli sviluppatori, mettendo nelle loro mani la capacità di integrare un’AI potente, efficiente e, soprattutto, rispettosa della privacy direttamente nelle proprie applicazioni.

L’enfasi sull’elaborazione on-device e su un’infrastruttura cloud sicura come Private Cloud Compute ridefinisce il paradigma dell’AI personale, promettendo esperienze utente più ricche e intuitive, senza sacrificare i dati personali. Si tratta di una vera e propria democratizzazione dell’AI avanzata, progettata per funzionare in armonia con l’hardware Apple Silicon e il linguaggio Swift.

Indice dei contenuti

I Nuovi Foundation Models di Apple: Architettura e Capacità

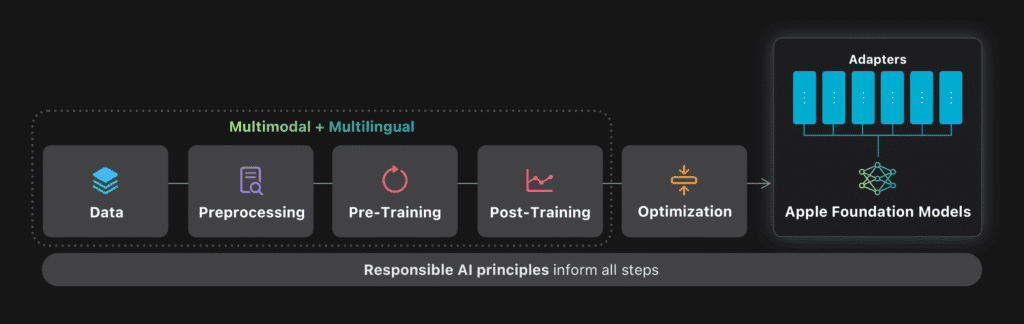

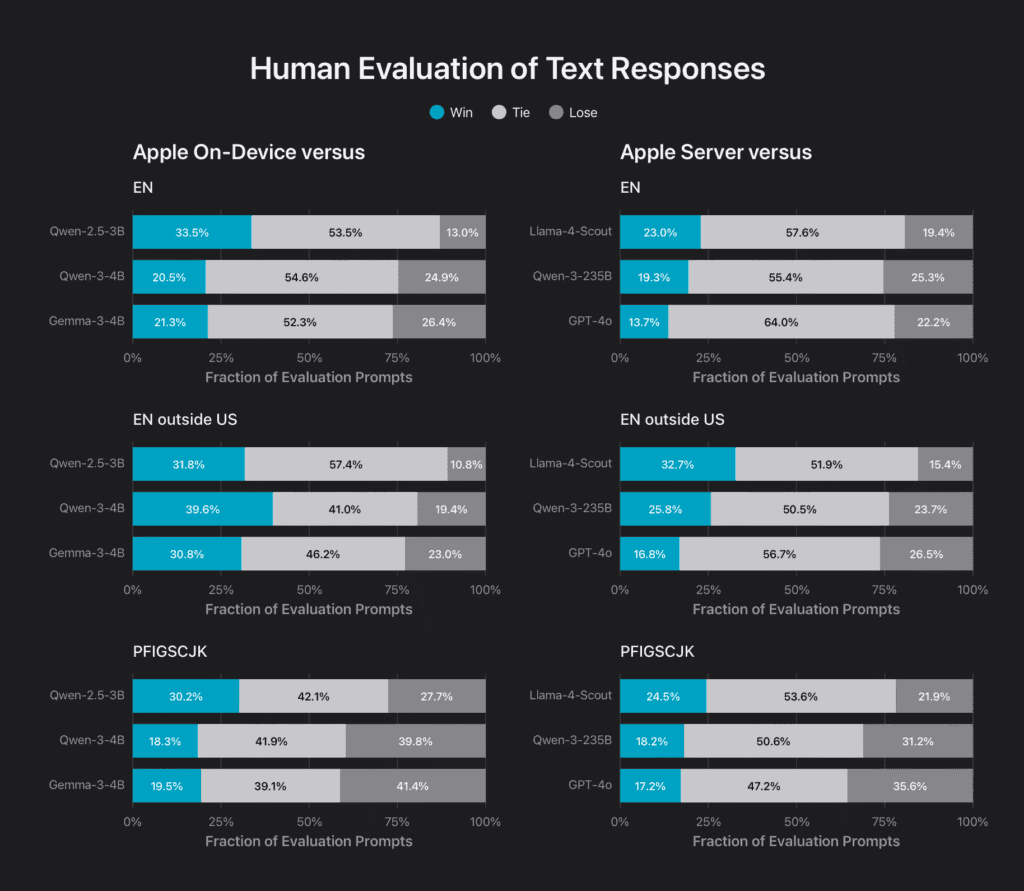

Al cuore della visione AI di Apple, presentata durante la WWDC 2025, ci sono i suoi Foundation Language Models di nuova generazione, progettati specificamente per le esigenze dell’ecosistema. Come illustrato nel dettaglio da Apple Machine Learning Research, questi modelli si dividono principalmente in due categorie:

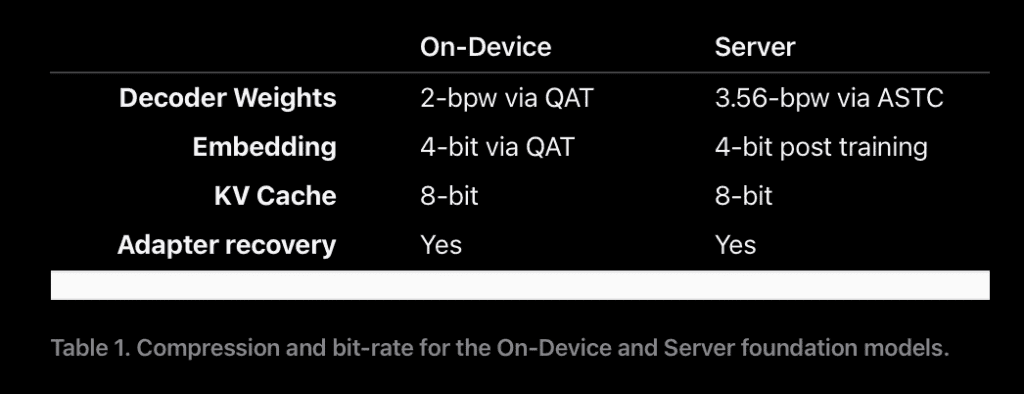

- un modello compatto da circa 3 miliardi di parametri, ottimizzato per l’esecuzione efficiente on-device su Apple Silicon

- un modello server più grande, basato su un’architettura mixture-of-experts (MoE) e progettato per il Private Cloud Compute quando sono necessarie capacità superiori.

L’architettura del modello on-device è stata ingegnerizzata per massimizzare l’efficienza, riducendo l’uso della memoria KV cache e migliorando la latenza. Entrambi i modelli beneficiano di un design che supporta input contestuali più lunghi e capacità multimodali, potendo comprendere sia testo che immagini.

L’addestramento è avvenuto su vasti dataset, che includono dati licenziati, informazioni disponibili pubblicamente e contenuti raccolti da Applebot, con una forte attenzione alla qualità e alla rimozione di informazioni personali identificabili.

Apple sottolinea di non utilizzare dati privati degli utenti o le loro interazioni per l’addestramento, seguendo protocolli etici e offrendo ai publisher la possibilità di opt-out.

Il Foundation Models Framework: Potenza AI nelle Mani degli Sviluppatori

La vera svolta per gli sviluppatori è rappresentata dal nuovo Foundation Models framework, un’API che, come riportato anche da iDownloadBlog, darà accesso diretto al modello on-device da ~3 miliardi di parametri. Questo framework è pensato per consentire l’integrazione di funzionalità AI – come riassunti, estrazione di entità, comprensione del testo, generazione di contenuti creativi e brevi dialoghi – direttamente all’interno delle app, con elaborazione locale.

Una delle cose più interessanti per chi crea le app è un sistema che Apple ha chiamato guided generation, che si integra perfettamente con Swift, il linguaggio di programmazione di Apple. In parole povere, gli sviluppatori possono dire all’intelligenza artificiale integrata: ‘Ok, ho bisogno che tu mi dia un risultato fatto così e cosà, con queste informazioni specifiche‘. Grazie a questa ‘guida’, l’AI capisce subito cosa deve fare e restituisce i dati già belli pronti e nel formato giusto, senza che lo sviluppatore debba impazzire a scrivere codice complicatissimo.

C’è un ‘demone’ (un piccolo programma che lavora dietro le quinte nel sistema operativo) che si assicura che tutto fili liscio e veloce, controllando che l’AI non ‘stoni’ e dia esattamente il tipo di risposta che l’app si aspetta. In più, c’è anche una funzione chiamata tool calling.

Immaginate che l’AI sia un bravissimo assistente, ma che per alcune cose specifiche (tipo controllare gli appuntamenti sul calendario o cercare un’informazione su un sito particolare) abbia bisogno di ‘chiamare un esperto’. Ecco, con il tool calling, gli sviluppatori possono dare all’AI l’accesso a questi ‘esperti’ (altri pezzi di software o servizi), così da renderla ancora più potente e utile per compiti specifici.

E per gli sviluppatori che vogliono proprio il massimo della personalizzazione, quelli che vogliono insegnare all’AI dei ‘trucchi del mestiere’ tutti nuovi, Apple mette a disposizione anche degli strumenti più avanzati (un toolkit in Python per creare degli ‘adattatori’, chiamati LoRA).

Vantaggi Concreti: Privacy, Efficienza e Innovazione per le App

L’approccio di Apple con i suoi Foundation Models e il relativo framework offre vantaggi tangibili. La privacy è al primo posto: l’elaborazione on-device minimizza la necessità di inviare dati sensibili a server esterni, un aspetto cruciale per la fiducia degli utenti. Questo si sposa perfettamente con la filosofia di Apple, che da sempre pone l’utente e la sicurezza dei suoi dati al centro.

L’efficienza è un altro pilastro. I modelli sono ottimizzati per Apple Silicon, garantendo bassa latenza e minimo impatto sulle risorse del dispositivo. Il Foundation Models framework promette di rendere l’accesso a queste capacità AI “gratuito” per gli sviluppatori (in termini di costi di inferenza cloud) e implementabile con poche righe di codice.

Questo abbassa la barriera d’ingresso per integrare funzionalità intelligenti sofisticate, permettendo anche a team più piccoli di innovare. Le app possono diventare più reattive, funzionare offline e offrire un livello di personalizzazione e intelligenza contestuale prima difficile da raggiungere su larga scala.

Scenari d’Uso e Implicazioni per il Futuro delle App Apple

Le implicazioni di questi annunci sono profonde. Immaginiamo app per la produttività che riassumono automaticamente lunghe email o documenti, app per l’apprendimento che generano quiz personalizzati dagli appunti (come nell’esempio mostrato da Apple), o app creative che aiutano a generare testo o idee. Il limite è dato dalla creatività degli sviluppatori, che ora hanno uno strumento potente e integrato per portare l’AI nelle loro creazioni.

L’enfasi sulla Responsible AI, come delineato da Apple, guida questo processo, fornendo anche linee guida di Human Interface per assicurare che le esperienze AI siano utili, comprensibili e rispettose. La capacità del modello on-device di gestire fino a 15 lingue e comprendere input visivi apre ulteriormente il campo a innovazioni in accessibilità, internazionalizzazione e interazioni multimodali.

Non si tratta solo di aggiungere “un po’ di AI”, ma di ripensare le interazioni fondamentali all’interno delle app.

Considerazioni e Prospettive Future

Naturalmente, l’adozione di tecnologie così avanzate comporta anche delle riflessioni. Sebbene il modello on-device sia potente per molti task, Apple stessa chiarisce che non è pensato per essere un chatbot con conoscenza generale del mondo paragonabile ai grandi modelli server. Gli sviluppatori dovranno comprendere i punti di forza e i limiti del modello per sfruttarlo al meglio.

La gestione degli adattatori, che necessitano di riaddestramento con ogni nuova versione del modello base, è un altro aspetto da considerare per chi necessita di specializzazioni profonde.

Tuttavia, la potenza del modello base, unita alla guided generation e al tool calling, dovrebbe coprire un’ampia gamma di esigenze. La continua evoluzione di questi modelli, come suggerito da Apple che promette futuri report tecnici, indica un impegno a lungo termine per potenziare ulteriormente queste capacità.

FAQ sui Foundation Models di Apple e il Nuovo Framework

D: Qual è la differenza principale tra il modello on-device e quello server di Apple?

R: Il modello on-device (~3 miliardi di parametri) è ottimizzato per efficienza e privacy, eseguendo task direttamente sul dispositivo. Il modello server è più grande e potente, utilizzato per task più complessi tramite Private Cloud Compute, mantenendo comunque un forte focus sulla privacy.

D: Il Foundation Models framework è difficile da usare per gli sviluppatori?

R: Apple ha progettato il framework per essere intuitivo, specialmente con l’approccio guided generation in Swift, che semplifica l’ottenimento di output strutturati dal modello. L’obiettivo è renderlo accessibile anche senza profonde competenze in machine learning.

D: Le mie app potranno usare l’AI di Apple anche offline?

R: Sì, uno dei grandi vantaggi del modello on-device accessibile tramite il framework è la capacità di eseguire task AI direttamente sull’hardware dell’utente, quindi anche in assenza di connessione internet.

D: Apple userà i dati delle mie app per addestrare i suoi modelli?

R: Apple ha dichiarato esplicitamente di non usare i dati privati degli utenti o le interazioni degli utenti (incluse quelle all’interno delle app terze che usano il framework) per addestrare i suoi modelli base. La privacy è un principio cardine.

D: Il framework supporta solo la generazione di testo?

R: Il modello on-device è primariamente un modello linguistico, ma ha capacità di comprendere input visivi. Il framework è focalizzato su task testuali come riassunto, comprensione, generazione creativa, ma le capacità multimodali del modello base potrebbero aprire a future evoluzioni.

Conclusione: L’Era dell’Intelligenza Artificiale Personale e Integrata di Apple

Con i suoi Foundation Models aggiornati e l’innovativo Foundation Models framework, Apple non sta semplicemente seguendo un trend, ma sta definendo la sua visione per un’intelligenza artificiale profondamente integrata, personale e rispettosa della privacy.

Per gli sviluppatori dell’ecosistema Apple, questa è un’opportunità senza precedenti per arricchire le proprie app con capacità AI sofisticate, aprendo la strada a una nuova generazione di esperienze utente. L’elaborazione on-device e l’approccio privacy-first sono i pilastri che sostengono questa rivoluzione, promettendo un futuro in cui l’AI non è solo potente, ma anche fidata e veramente al servizio dell’utente.