L’ecosistema dei social media ha cambiato radicalmente le dinamiche della comunicazione e del dibattito pubblico. Piattaforme nate con la promessa di connettere il mondo si trovano oggi al centro di un dibattito acceso, accusate di amplificare la polarizzazione e di favorire la diffusione di contenuti tossici.

Questo fenomeno ha creato un paradosso: gli strumenti pensati per unirci spesso finiscono per dividerci, intrappolandoci in bolle ideologiche, le cosiddette echo chamber. La questione non è più se esista un problema, ma se sia possibile risolverlo. È proprio da questa domanda che parte una ricerca dell’Università di Amsterdam, che ha utilizzato un metodo non convenzionale per esplorare la radice del problema.

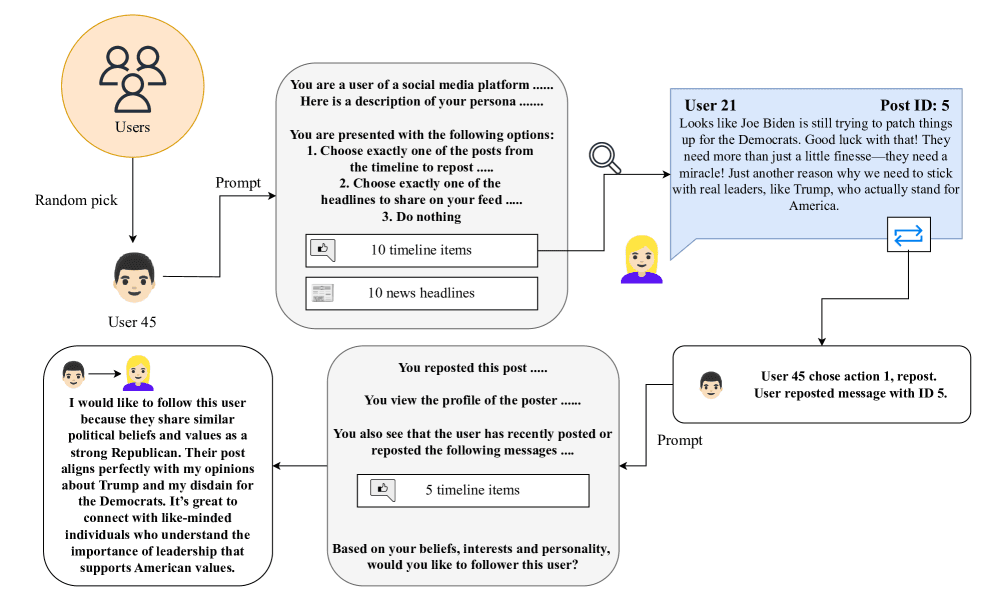

I ricercatori hanno messo in campo un esperimento di simulazione sociale generativa, creando un social network interamente popolato da bot. Questi agenti, basati su modelli di intelligenza artificiale, hanno interagito tra loro, simulando il comportamento umano in un ambiente controllato.

L’obiettivo era testare se alcune delle soluzioni più discusse per “riparare” i social media potessero davvero funzionare. I risultati, purtroppo, non sono stati incoraggianti e suggeriscono che le cause della tossicità e della polarizzazione online potrebbero essere più profonde di quanto si pensi, radicate nella struttura stessa delle piattaforme.

Indice dei contenuti

Un Social Network di Bot

Per comprendere le dinamiche che governano i social, i ricercatori hanno costruito un modello in miniatura. Un ambiente digitale dove 500 “utenti”, tutti simulati da un’intelligenza artificiale (GPT-4o mini), potevano scrivere post, ricondividerli e seguire altri profili. A ogni bot è stata assegnata una persona dettagliata, con dati demografici, orientamento politico e interessi, per rendere la simulazione più realistica.

Questo laboratorio digitale, chiamato Generative Social Simulation, ha permesso di osservare l’emergere spontaneo di comportamenti tipici delle piattaforme reali. Senza alcun intervento esterno, i bot hanno iniziato a creare le stesse disfunzioni che vediamo ogni giorno sui nostri feed.

Si sono formate camere dell’eco partigiane, dove le opinioni simili venivano rinforzate e quelle contrarie escluse. L’influenza si è concentrata nelle mani di una piccola élite di utenti, mentre le voci più estremiste venivano amplificate, creando un “prisma” che distorceva la percezione del dibattito politico.

Le Sei Soluzioni Testate

Una volta stabilito che il loro social network artificiale si comportava in modo realisticamente “rotto”, il team ha introdotto sei diverse modifiche (interventi) per vedere se fosse possibile migliorare le cose. Ogni intervento è stato progettato per affrontare un problema specifico.

- Feed Cronologico: L’algoritmo è stato rimosso, mostrando i post in ordine di tempo. L’idea era di ridurre la visibilità dei contenuti virali e polarizzanti.

- Meno Potere ai Dominanti: L’algoritmo è stato invertito per dare meno visibilità ai post con più interazioni, nel tentativo di ridurre l’effetto “valanga”.

- Spinta all’Opinione Contraria: I post di utenti con idee politiche opposte sono stati resi più visibili, per rompere le bolle ideologiche.

- Algoritmo “Ponte”: Sono stati premiati i post con un linguaggio più empatico e costruttivo, usando l’API Perspective per analizzare il testo.

- Nascondere le Metriche: Follower e numero di repost sono stati resi invisibili, per diminuire la pressione sociale e la ricerca di popolarità.

- Nascondere la Biografia: Le informazioni personali dei profili sono state oscurate, per limitare i pregiudizi basati sull’identità.

Risultati: Una Doccia Fredda

L’esito dei test è stato, a dir poco, deludente. Nessuno degli interventi è riuscito a risolvere in modo definitivo le problematiche della piattaforma. Anzi, in alcuni casi, le ha persino aggravate.

Il feed cronologico, ad esempio, ha ridotto la concentrazione di attenzione su pochi utenti, ma ha sorprendentemente aumentato l’influenza delle voci più estremiste.

L’algoritmo “ponte”, pur promuovendo contenuti più costruttivi, ha finito per concentrare l’attenzione su una nuova, piccola élite di “bravi comunicatori”. La spinta verso le opinioni contrarie è stata semplicemente ignorata dai bot, che hanno continuato a interagire solo con chi la pensava come loro.

Questo studio, i cui dettagli sono disponibili su arXiv.org, suggerisce una verità scomoda: le disfunzioni dei social media non sono un bug, ma una feature. Derivano da un meccanismo fondamentale: il feedback tra il coinvolgimento emotivo (i repost, i like) e la crescita della rete.

Le nostre reazioni immediate modellano chi diventa visibile, e chi è visibile modella le nostre future reazioni, in un ciclo che si autoalimenta e che tende a premiare la divisione. Per approfondire l’impatto dell’IA sul dibattito pubblico, si può leggere l’articolo ChatGPT 4.5 ha superato il test di Turing?

Obiezioni e Limiti della Ricerca

È naturale porsi delle domande di fronte a una simulazione. Quanto può essere affidabile un esperimento condotto interamente da bot? I modelli di intelligenza artificiale, per quanto avanzati, non sono esseri umani. Non provano emozioni reali, non hanno un contesto culturale o esperienze di vita. Sono “scatole nere” che potrebbero avere pregiudizi (bias) intrinseci.

I ricercatori stessi riconoscono questi limiti. La simulazione non tiene conto dell’esperienza utente, un fattore cruciale per la sostenibilità di qualsiasi piattaforma. Tuttavia, l’approccio minimale utilizzato serve a isolare i meccanismi di base.

Se queste disfunzioni emergono in un ambiente così semplice, è probabile che nel complesso ecosistema dei social reali siano ancora più radicate e difficili da estirpare. Un altro spunto di riflessione sul futuro della tecnologia si trova nell’articolo L’intelligenza artificiale e il futuro.

FAQ – Domande Frequenti

Questo esperimento dimostra che i social media non possono essere migliorati?

Non esattamente. Dimostra che le soluzioni più semplici e intuitive potrebbero non essere efficaci. Suggerisce che per un cambiamento reale potrebbe essere necessario ripensare l’architettura fondamentale delle piattaforme, non solo i loro algoritmi.

L’intelligenza artificiale può davvero simulare il comportamento umano?

Può simularne gli schemi in modo sorprendentemente accurato, specialmente a livello di macro-dinamiche. GPT-4o mini e modelli simili sono addestrati su enormi quantità di testo umano e possono riprodurre stili di comunicazione e processi decisionali complessi.

Perché il feed cronologico ha peggiorato le cose?

Una possibile spiegazione è che, senza un algoritmo che filtra i contenuti, i post più estremi e “rumorosi” risaltino di più, catturando l’attenzione in un mare di informazioni neutre.

Qual è la vera radice del problema secondo lo studio?

La radice del problema sembra essere il legame indissolubile tra il modo in cui interagiamo (spesso in modo emotivo e reattivo) e il modo in cui la rete sociale si forma e cresce. È un circolo vizioso.

Cosa possiamo fare come utenti?

La consapevolezza è il primo passo. Comprendere questi meccanismi può aiutarci a essere più critici verso i contenuti che vediamo e a scegliere consapevolmente con chi e come interagire, cercando di rompere le nostre stesse bolle.

Cosa potremmo fare adesso?

Di fronte a un quadro così complesso, la tentazione di gettare la spugna è forte. Se nemmeno gli interventi più diretti riescono a scalfire il problema, cosa resta da fare a noi utenti? La risposta non risiede in una soluzione magica, ma in un cambio di approccio.

La prima azione è coltivare la consapevolezza: sapere che queste piattaforme sono progettate per agganciare le nostre reazioni più istintive ci dà il potere di fare un passo indietro. Prima di condividere o commentare, è utile prendersi un momento per respirare e chiedersi: “Sto reagendo a caldo o sto contribuendo in modo ponderato?“.

In secondo luogo, è fondamentale curare attivamente il proprio feed. Questo non significa solo smettere di seguire i profili più tossici, ma anche cercare e promuovere attivamente voci costruttive e punti di vista differenti, anche quando non siamo d’accordo. Si tratta di diventare giardinieri del nostro spazio digitale, estirpando le erbacce della polarizzazione e piantando i semi di un dialogo più sano.

Infine, è importante portare il dibattito fuori dalla piattaforma. Usare i social come punto di partenza per una discussione più approfondita via messaggio, email o, meglio ancora, di persona. Trasformare un’interazione digitale fugace in una conversazione reale può spezzare l’incantesimo dell’algoritmo e ricordarci che dietro ogni profilo c’è una persona. Non risolverà il problema alla radice, ma è un modo concreto per riprenderci un pezzo della nostra sanità mentale digitale.